La inteligencia artificial predice la raza de los pacientes a partir de sus imágenes médicas

La mala educación de los algoritmos es un problema crítico; cuando la inteligencia artificial refleja los pensamientos inconscientes, el racismo y los prejuicios de los humanos que generaron estos algoritmos, puede provocar daños graves. Los programas de computadora, por ejemplo, han señalado erróneamente que los acusados negros tienen el doble de probabilidades de reincidir que los blancos. Cuando una IA usó el costo como indicador de las necesidades de salud, nombró falsamente a los pacientes negros como más saludables que los blancos igualmente enfermos, ya que se gastó menos dinero en ellos. Incluso AI solía escribir una obra de teatro basada en el uso de estereotipos dañinos.

La eliminación de características confidenciales de los datos parece un ajuste viable. Pero, ¿qué sucede cuando no es suficiente?

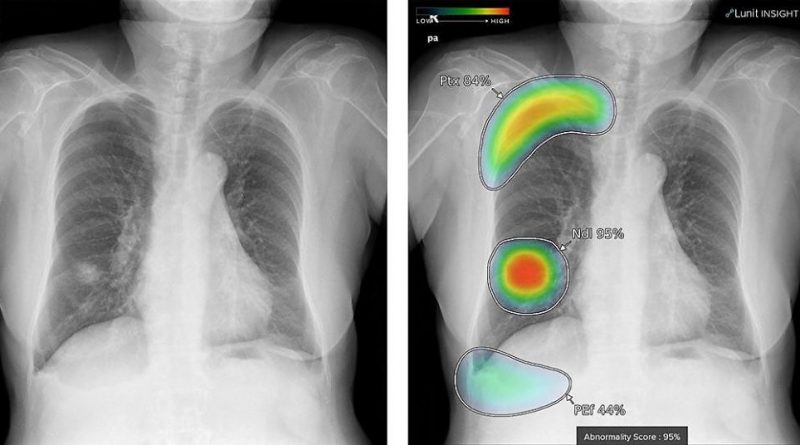

Los ejemplos de sesgo en el procesamiento del lenguaje natural son ilimitados, pero los científicos del MIT han investigado otra modalidad importante, en gran parte poco explorada: las imágenes médicas. Usando conjuntos de datos privados y públicos, el equipo descubrió que la IA puede predecir con precisión la raza de pacientes autoinformada solo a partir de imágenes médicas. Usando datos de imágenes de radiografías de tórax, radiografías de extremidades, tomografías computarizadas de tórax y mamografías, el equipo entrenó un modelo de aprendizaje profundo para identificar la raza como blanca, negra o asiática, aunque las imágenes en sí no contenían una mención explícita de la raza. raza del paciente. Esta es una hazaña que incluso los médicos más experimentados no pueden hacer, y no está claro cómo el modelo pudo hacer esto.

En un intento por desentrañar y dar sentido al enigmático «cómo» de todo esto, los investigadores realizaron una serie de experimentos. Para investigar los posibles mecanismos de detección de razas, observaron variables como las diferencias en la anatomía, la densidad ósea, la resolución de las imágenes y muchas más, y los modelos aún prevalecían con una alta capacidad para detectar razas a partir de radiografías de tórax. «Estos resultados inicialmente fueron confusos, porque los miembros de nuestro equipo de investigación no pudieron acercarse a identificar un buen representante para esta tarea», dice el coautor del artículo Marzyeh Ghassemi, profesor asistente en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación del MIT. y el Instituto de Ingeniería y Ciencias Médicas (IMES), que es una filial del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) y de la Clínica MIT Jameel. «Incluso cuando filtra imágenes médicas más allá de donde las imágenes son reconocibles como imágenes médicas, los modelos profundos mantienen un rendimiento muy alto. Eso es preocupante porque las capacidades sobrehumanas son generalmente mucho más difíciles de controlar, regular y evitar que dañen a las personas».

En un entorno clínico, los algoritmos pueden ayudarnos a decirnos si un paciente es candidato para la quimioterapia, dictar el triaje de los pacientes o decidir si es necesario un traslado a la UCI. «Creemos que los algoritmos solo analizan los signos vitales o las pruebas de laboratorio, pero es posible que también analicen su raza, etnia, sexo, si está encarcelado o no, incluso si toda esa información está oculta». dice el coautor del artículo Leo Anthony Celi, científico investigador principal en IMES en el MIT y profesor asociado de medicina en la Escuela de Medicina de Harvard. «El hecho de que tenga representación de diferentes grupos en sus algoritmos no garantiza que no perpetúe o amplíe las disparidades e inequidades existentes. Alimentar los algoritmos con más datos con representación no es una panacea. Este documento debería hacernos hacer una pausa y reconsiderar verdaderamente si estamos listos para llevar la IA al lado de la cama».

El estudio, «Reconocimiento de la IA de la raza del paciente en imágenes médicas: un estudio de modelado», se publicó en The Lancet Digital Health el 11 de mayo. Celi y Ghassemi escribieron el artículo junto con otros 20 autores en cuatro países.

Para configurar las pruebas, los científicos primero demostraron que los modelos podían predecir la carrera en múltiples modalidades de imágenes, varios conjuntos de datos y diversas tareas clínicas, así como en una variedad de centros académicos y poblaciones de pacientes en los Estados Unidos. Utilizaron tres grandes conjuntos de datos de rayos X de tórax y probaron el modelo en un subconjunto invisible del conjunto de datos utilizado para entrenar el modelo y en uno completamente diferente. Luego, entrenaron a los modelos de detección de identidad racial para imágenes de rayos X que no son de tórax de múltiples ubicaciones del cuerpo, incluidas radiografías digitales, mamografías, radiografías laterales de la columna cervical y tomografías computarizadas de tórax para ver si el rendimiento del modelo se limitaba a las radiografías de tórax.

El equipo cubrió muchas bases en un intento de explicar el comportamiento del modelo: diferencias en las características físicas entre diferentes grupos raciales (habitus corporales, densidad mamaria), distribución de enfermedades (estudios anteriores han demostrado que los pacientes negros tienen una mayor incidencia de problemas de salud como enfermedades cardíacas ), diferencias específicas de la ubicación o del tejido, los efectos del sesgo social y el estrés ambiental, la capacidad de los sistemas de aprendizaje profundo para detectar la raza cuando se combinaron múltiples factores demográficos y del paciente, y si regiones específicas de la imagen contribuyeron a reconocer la raza.