Investigadores lanzan simulador fotorrealista de código abierto para conducción autónoma

Los mundos virtuales hiperrealistas han sido anunciados como las mejores escuelas de conducción para vehículos autónomos (AV), ya que han demostrado ser bancos de pruebas fructíferos para probar escenarios de conducción peligrosos de forma segura. Tesla, Waymo y otras empresas de vehículos autónomos dependen en gran medida de los datos para habilitar simuladores fotorrealistas caros y patentados, ya que probar y recopilar datos matizados de casi accidente no suele ser lo más fácil o deseable de recrear.

Con ese fin, los científicos del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT crearon «VISTA 2.0», un motor de simulación basado en datos donde los vehículos pueden aprender a conducir en el mundo real y recuperarse de escenarios cercanos a un choque. Además, todo el código está abierto al público.

«Hoy en día, solo las empresas tienen software como el tipo de entornos de simulación y capacidades de VISTA 2.0, y este software es propietario. Con este lanzamiento, la comunidad de investigación tendrá acceso a una nueva y poderosa herramienta para acelerar la investigación y el desarrollo de control robusto adaptativo. para la conducción autónoma», dice la profesora del MIT y directora de CSAIL, Daniela Rus, autora principal de un artículo sobre la investigación.

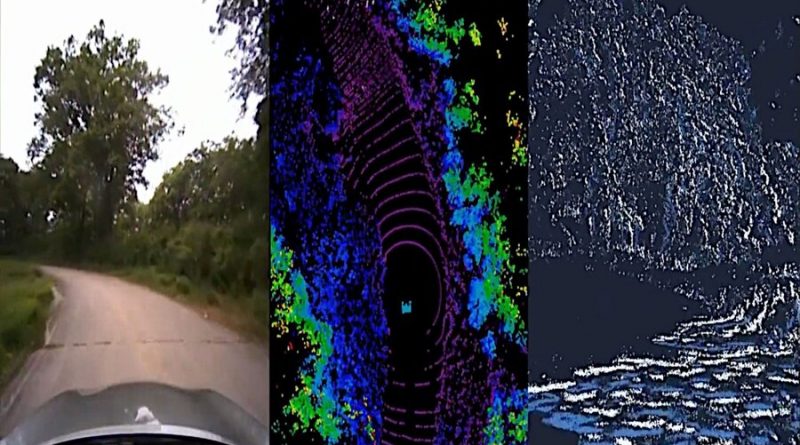

VISTA 2.0 se basa en el modelo anterior del equipo, VISTA, y es fundamentalmente diferente de los simuladores AV existentes, ya que está basado en datos, lo que significa que fue construido y renderizado de manera fotorrealista a partir de datos del mundo real, lo que permite la transferencia directa a la realidad. Si bien la iteración inicial solo admitía el seguimiento de carril de un solo automóvil con un sensor de cámara, lograr una simulación basada en datos de alta fidelidad requería repensar los fundamentos de cómo se pueden sintetizar diferentes sensores e interacciones de comportamiento.

«Este es un salto masivo en las capacidades de simulación basada en datos para vehículos autónomos, así como el aumento de la escala y la capacidad para manejar una mayor complejidad de conducción», dice Alexander Amini, CSAIL Ph.D. estudiante y coautor principal de dos nuevos artículos, junto con su compañero Ph.D. estudiante Tsun-Hsuan Wang. «VISTA 2.0 demuestra la capacidad de simular datos de sensores mucho más allá de las cámaras 2D RGB, pero también lidars 3D de dimensiones extremadamente altas con millones de puntos, cámaras basadas en eventos cronometrados irregularmente e incluso escenarios interactivos y dinámicos con otros vehículos».